GITHUB:https://github.com/hangzhaomit/semantic-segmentation-pytorch

chmod +x download_ADE20K.sh ./download_ADE20K.sh

python train.py --batch_size_per_gpu 4

(用的单卡1080ti 建议 8 以下,否则爆内存) 官方建议 2 – 8 个 Titan xp

不加 batch_size_per_gpu 的时候,报如下错误。

THCudaCheck FAIL file=/tmp/luarocks_cutorch-scm-1-3726/cutorch/lib/THC/generic/THCStorage.cu line=66 error=2 : out of memory

Training ….

epoch 一共 100轮,跑了 10几个小时,跑了26。用 20 轮的测一下

python test.py --id MODEL_ID --test_img TEST_IMG

MODEL_ID 是 ./ckpt/ 下某一个子目录的名字

命令大概长这样

python3 test.py --test_img demo1.png --id baseline-resnet34_dilated8-c1_bilinear-ngpus1-batchSize4-imgSize384-segSize384-lr_encoder0.001-lr_decoder0.01-epoch100-decay0.0001 --suffix _epoch100.pth

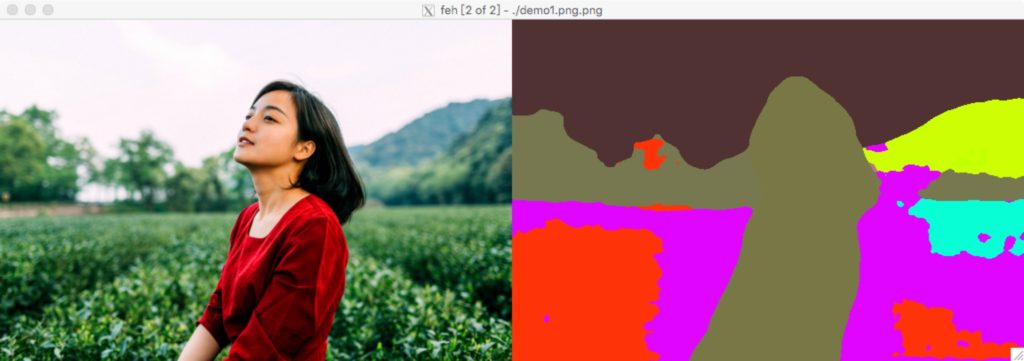

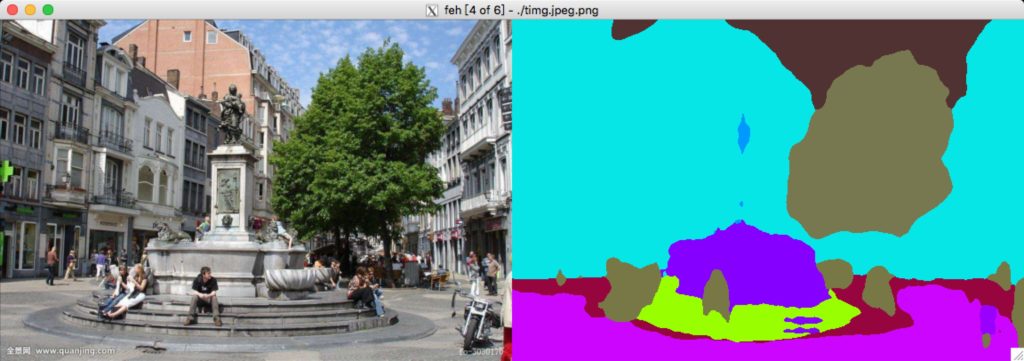

测试结果

50轮了,测试发现结果是一样的。。。

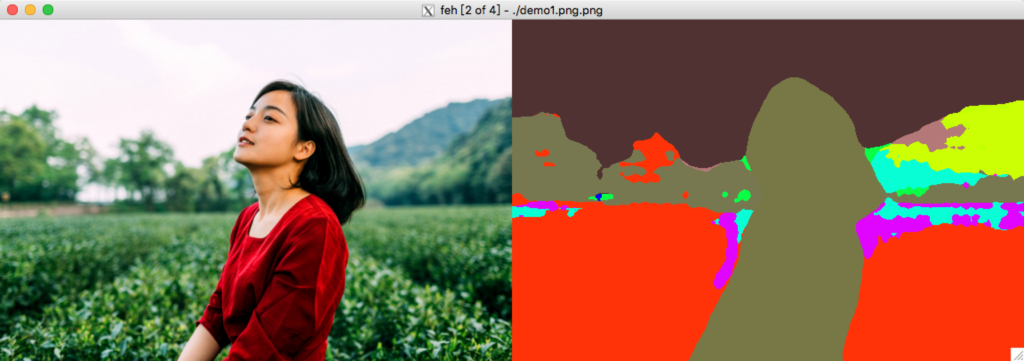

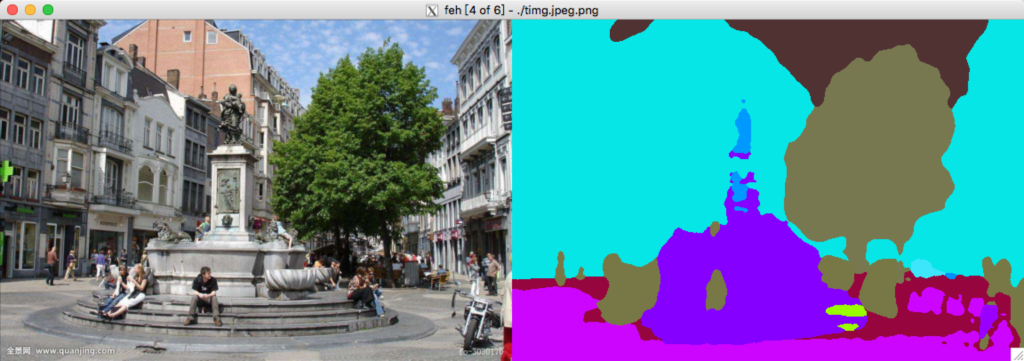

100轮结束后的效果